Antivirus: Dochutit špagety benzínem nebo do pizzy lepidlo. Co všechnu umí poradit chatbot?

Padá vám sýr z domácí pizzy? Pomůže školní lepidlo. Špagety ochutí omáčka z benzínu, a pokud vám vaše kočka olizuje ruce, tak zjišťuje, zda by vás nemohla sežrat. Internet se posmívá vyhledávači Google, který začal odpovědi na některé otázky generovat umělou inteligencí, ze které někdy padají vtipné nesmysly. Je to ale opravdu k smíchu?

Čtěte také

Opravdu Google radí lidem, aby přidali do pizzy lepidlo? „Jde o jednu z odpovědí, která se objevila v nové sekci, kterou Google zavádí, v takzvaných AI Overview,“ objasňuje redaktor Jan Cibulka s tím, že sekce zatím nejsou v Česku dostupné, fungují ve Spojených státech amerických.

„Jde o pokračování trendu, kdy, pokud hledáte nějaký návod nebo recept, tak vám Google nejdříve ukáže přímo odpověď na vaši otázku, a teprve pod ní pak najdete odkazy na weby, odkud Google informace sebral.“

Nesmyslné recepty

Lidé nyní sdílí některé z vtipných úletů technologie, když radí nesmyslné recepty na špagety s benzínem, nebo tvrdí, že když vám kočka olizuje ruce, tak vás chce sežrat.

„Google se brání, že tyhle nesmyslné odpovědi se objevují jen výjimečně a v případě velmi specifických dotazů, ale ukazuje to na několik problémů, které nám přináší překotná snaha technologických firem najít nějaké uplatnění pro generativní jazykové modely, o kterých se dnes mluví souhrnně jako o umělé inteligenci.“

Domýšlí text

Čtěte také

Že chatboty ne vždycky říkají pravdu, je známé. Tenhle fenomén se označuje někdy jako halucinace: generativní jazykové modely se, hodně zjednodušeně, snaží domýšlet, jak by nejpravděpodobněji mohl pokračovat nějaký kus textu.

„Proto když jim dáte otázku, dostanete obvykle nějakou odpověď, která se často blíží realitě. Jenže model v našem lidském slova smyslu nechápe, o čem mluví, jen hledá nejpravděpodobněji vypadající text,“ vysvětluje Cibulka.

Například chatbot státu New York radil malým podnikatelům porušovat zákony, aby dosáhli rychlých zisků a jejich malé firmy rychle rostly.

„Podle agentury AP falešně navrhl, že je legální, aby zaměstnavatel propustil pracovníka, který si stěžuje na sexuální obtěžování, neprozradí těhotenství nebo si odmítne ostříhat dredy. Chatbot dál tvrdil, že restaurace mají stále právo podávat jídlo, ke kterému mají přístup krysy.“

Vtípky na Redditu

Ale přeci si tak velká technologická společnost, jako je Google, musí být tohoto rizika vědomá – proč si to neohlídala?

„Google se to ohlídat snažil, proto nová funkce odpovědi nevymýšlí, ale pouze sumarizuje rady, co našla online. A tady se dostáváme k jádru toho lepidlového receptu: Google jako studnici znalostí používá mimo jiné i stránku Reddit, jde o diskusní fórum, kde lidé debatují o všem možném, a třeba si radí.“

Čtěte také

Na Redditu sice najdete plno dobrých rad, ale je také plný nejrůznějších vtípků. Konkrétně ta rada s lepidlem se objevila v jedenáct let starém příspěvku uživatele s lehce vulgární přezdívkou, a byla zjevně myšlená jako vtip. Stejně jako tvrzení, že když vám kočka olizuje ruce, tak to není projev náklonnosti, ale signál, že vás chce sežrat.

„Když na takový příspěvek narazíte v diskuzi na fóru, kde i řada jiných lidí dělá vtipy, tak je vám jasné, odkud vítr vane. Problém ale nastane, když takový vtípek vezme generativní umělá inteligence, která nechápe obsah, a s dalšími informacemi ho sumarizuje do něčeho, co vypadá suverénně a důvěryhodně.“

Bájná lhavost

Čtěte také

Vyřešit tuhle „bájnou lhavost“ nebude snadné, a možná i nemožné. Což by nemusel být obří problém, pokud by tedy všechny velké technologické firmy nespěchaly s nasazováním umělé inteligence do všech svých produktů.

„Potom to právě vede k situacím, že třeba vyhledávač Google, který jsme se naučili brát jako spolehlivý zdroj informací, radí takové nesmysly. A dovedeme si představit, že někdy by taková rada nemusela být tak viditelně nesmyslná, ale o nic méně nebezpečná.“

Známý je příklad s určováním hub: chatbot je schopný vám u jedovaté houby suverénně poradit, že je jedlá. „Proto bude potřeba větší opatrnost při hledání rad na internetu,“ uzavírá Cibulka.

Související

-

Virtuální asistenti jsou čím dál dokonalejší. Čeština jim ale dává zabrat

Možná občas využíváte pomoc asistenta, třeba když vybíráte zboží v e-shopu nebo zadáváte platební příkaz. A napadlo vás, že možná nekomunikujete s člověkem, ale s robotem?

-

Magazín Experiment ŽIVĚ z ČVUT: Umělá inteligence a její budoucnost

Co je umělá inteligence? Kdo za ní stojí a jak nám může pomáhat v budoucnosti? Poslechněte si speciální živé vysílání z dejvického kampusu pražského ČVUT.

-

Ve škole i v domově seniorů. Kde všude pomáhá umělá inteligence?

Kde všude pomáhá lidem umělá inteligence? Poslouchejte seriál Radiožurnálu každý den v 8:50. V sobotu věnujeme tématu speciální Magazín Experiment.

Více z pořadu

E-shop Českého rozhlasu

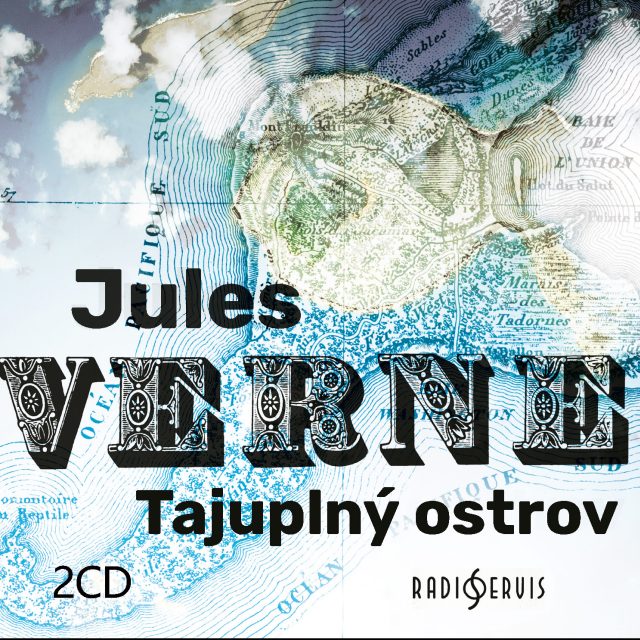

Vždycky jsem si přál ocitnout se v románu Julese Verna. Teď se mi to splnilo.

Václav Žmolík, moderátor

Tajuplný ostrov

Lincolnův ostrov nikdo nikdy na mapě nenašel, a přece ho znají lidé na celém světě. Už déle než sto třicet let na něm prožívají dobrodružství s pěticí trosečníků, kteří na něm našli útočiště, a hlavně nejedno tajemství.